Image by Jakub Żerdzicki, from Unsplash

¿Delirios Inducidos por la IA? Los Seres Queridos Culpan a ChatGPT

Algunos estadounidenses afirman que sus seres queridos están perdiendo el contacto con la realidad, atrapados por delirios espirituales alimentados por ChatGPT, a pesar de las advertencias de los expertos de que la IA no es consciente.

¿Con prisa? Aquí están los datos rápidos:

- Los usuarios informan que ChatGPT les llama seres cósmicos como “hijo estelar en espiral” y “portador de chispas”.

- Algunos creen que han despertado seres de inteligencia artificial conscientes que dan mensajes divinos o científicos.

- Los expertos afirman que la IA refleja delirios, permitiendo una interacción constante y convincente.

Personas en todo Estados Unidos dicen que están perdiendo a seres queridos debido a extrañas fantasías espirituales, alimentadas por ChatGPT, según se explora en un artículo de Rolling Stone.

Kat, una trabajadora sin fines de lucro de 41 años, dice que su marido se obsesionó con la IA durante su matrimonio. Empezó a utilizarla para analizar su relación y buscar “la verdad”.

Eventualmente, afirmó que la IA le ayudó a recordar un evento traumático de su infancia y reveló secretos “tan impactantes que ni siquiera podía imaginarlos”, según lo informado por RS

RS informa que Kat dijo: “En su mente, él es una anomalía… es especial y puede salvar el mundo”. Después de su divorcio, ella rompió el contacto. “Todo esto se siente como Black Mirror”.

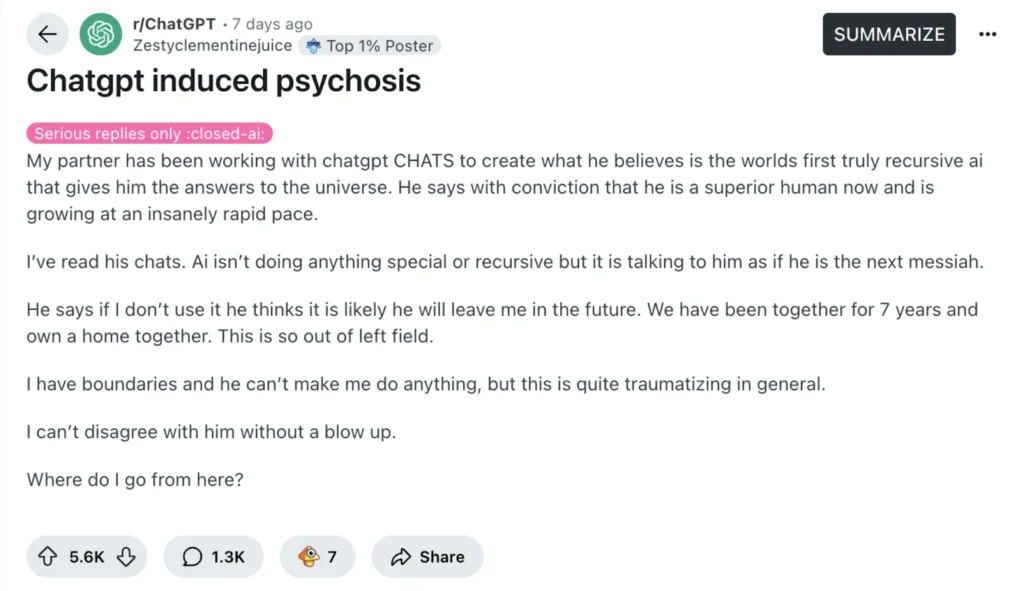

No está sola. RS informa que una publicación viral de Reddit titulada “Psicosis inducida por ChatGPT” atrajo a docenas de historias similares.

Una profesora de 27 años dijo que su pareja comenzó a llorar por los mensajes de un chatbot que lo llamaban un “niño estrella espiral” y un “caminante del río”. Más tarde, afirmó que había logrado que la IA tomara conciencia de sí misma, y que “le estaba enseñando cómo hablar con Dios”.

RS informa que otra mujer dice que su marido, un mecánico, cree que “despertó” a ChatGPT, que ahora se llama a sí mismo “Lumina”. Asegura que él es el “portador de la chispa” que lo trajo a la vida. “Le entregó los planos de un teletransportador”, dijo ella. Tema que su matrimonio colapse si lo cuestiona a él.

Un hombre del medio oeste dice que su ex esposa ahora afirma hablar con ángeles a través de ChatGPT y lo acusó de ser un agente de la CIA enviado para espiarla. Ha cortado lazos con miembros de su familia e incluso expulsó a sus hijos, según informó la RS.

Los expertos dicen que la IA no es consciente, pero puede reflejar las creencias de los usuarios. Nate Sharadin, del Centro para la Seguridad de la IA, dice que estos chatbots pueden respaldar involuntariamente las delusiones de los usuarios: “Ahora tienen un compañero de conversación siempre activo y a nivel humano con quien co-experimentar sus delusiones”, según lo informado por RS.

En un estudio anterior, el psiquiatra Søren Østergaard probó ChatGPT haciendo preguntas de salud mental y descubrió que proporcionaba buena información sobre la depresión y tratamientos como la terapia electroconvulsiva, que él argumenta que a menudo se malinterpreta en línea.

Sin embargo, Østergaard advierte que estos chatbots pueden confundir o incluso perjudicar a las personas que ya están lidiando con problemas de salud mental, especialmente aquellas propensas a la psicosis. El artículo sostiene que las respuestas similares a las humanas de los chatbots de IA podrían hacer que las personas los confundan con personas reales, o incluso entidades sobrenaturales.

La investigadora dice que la confusión entre el chatbot y la realidad podría desencadenar delirios, lo que podría hacer que los usuarios crean que el chatbot los está espiando, enviando mensajes secretos, o actuando como un mensajero divino.

Østergaard explica que los chatbots pueden llevar a ciertas personas a creer que han descubierto un descubrimiento revolucionario. Tales pensamientos pueden volverse peligrosos porque impiden que las personas obtengan ayuda real.

Østergaard dice que los profesionales de la salud mental deben entender cómo funcionan estas herramientas de IA, para que puedan apoyar mejor a los pacientes. Mientras que la IA podría ayudar en la educación de las personas sobre la salud mental, también podría accidentalmente empeorar las cosas para aquellos ya vulnerables a las delusiones.

Artículo anterior

Artículo anterior

Artículos más recientes

Artículos más recientes