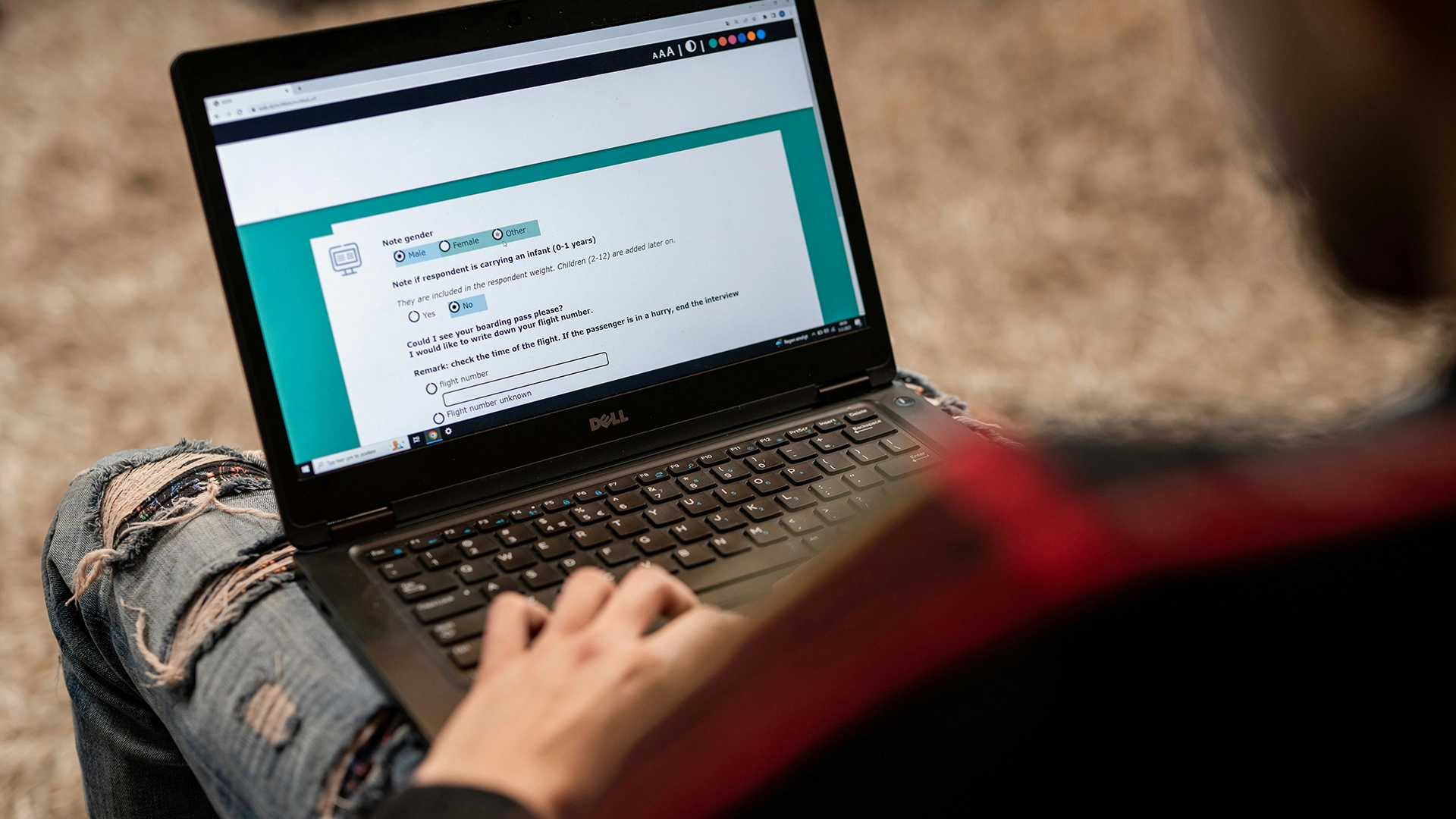

Image by ODISSEI, from Unsplash

Casi la Mitad de las Respuestas a Encuestas en Línea Podrían Provenir de IA, Según un Estudio

La investigación de comportamiento en línea, que anteriormente se consideraba un método confiable para estudiar la psicología humana, ahora enfrenta un problema importante ya que los participantes utilizan herramientas de IA como los chatbots para generar sus respuestas.

¿Apurado? Aquí están los datos rápidos:

- El 45% de los participantes en la encuesta de Prolific pegaron respuestas generadas por IA.

- Los investigadores encontraron que el texto del chatbot a menudo parecía “excesivamente verboso” o “no humano”.

- Los expertos denominan a este problema “Contaminación LLM”, lo que amenaza la validez de la investigación del comportamiento.

Investigadores del Instituto Max Planck para el Desarrollo Humano en Berlín recientemente investigaron cuán extendido está el problema en plataformas como Prolific, la cual paga a voluntarios para completar encuestas.

“Las tasas de incidencia que estábamos observando eran realmente impactantes”, dice la investigadora principal Anne-Marie Nussberger, según lo informado por New Scientist (NS).

En una prueba, el 45 por ciento de los participantes parecía pegar contenido generado por un chatbot en un cuadro de respuesta de texto libre. Las respuestas a menudo mostraban signos como “excesivamente verboso” o “lenguaje marcadamente no humano”.

“De los datos que recogimos a principios de este año, parece que una proporción sustancial de los estudios está contaminada”, dijo Nussberger a NS.

Para detectar respuestas sospechosas, su equipo introdujo trampas ocultas. Los reCAPTCHAs básicos señalaron al 0.2 por ciento de los usuarios, una versión más avanzada atrapó al 2.7 por ciento, un texto invisible que pedía la palabra “avellana” enredó al 1.6 por ciento, y la prohibición de copiar y pegar reveló otro 4.7 por ciento.

El problema ha evolucionado a lo que los expertos ahora llaman “Contaminación LLM”, que se extiende más allá del engaño. El estudio de investigación revela tres patrones de interferencia de la IA: Mediación Parcial (la IA ayuda con la redacción o la traducción), Delegación Completa (la IA realiza estudios completos) y Desbordamiento (los humanos modifican sus acciones porque anticipan la presencia de la IA).

“Lo que necesitamos hacer no es desconfiar completamente de la investigación en línea, sino responder y reaccionar”, dice Nussberger, instando a las plataformas a tomar el problema en serio, según informó NS..

Matt Hodgkinson, un consultor de ética en investigación, advierte a NS: “La integridad de la investigación del comportamiento en línea ya estaba siendo cuestionada […] Los investigadores necesitan trabajar colectivamente para encontrar formas de verificar a distancia la participación humana o volver al enfoque antiguo de contacto cara a cara.”

Prolific se negó a comentar a NS.

Artículo anterior

Artículo anterior

Artículos más recientes

Artículos más recientes